‘Zelfs nu we elkaar via een scherm zien speelt onze blik een grote rol in het gesprek”, zegt Chinmaya Mishra (34). „Door de manier waarop je wegkijkt als je een vraag stelt, weet ik dat je nadenkt over je formulering en begrijp ik dat ik niet moet storen. Stel we zouden tegelijk bij de koffieautomaat staan, dan coördineren we onze bewegingen ook grotendeels met onze blik. Je kijkt eerst naar het koffiekopje, daarna beweeg je je hand. Alleen al doordat je kijkt wacht ik even, anders ligt er overal koffie. Het interpreteren van elkaars blik is heel belangrijk in communicatie.”

Maar hoe zorg je dat een robot dit subtiele menselijke gedrag ook goed onder de knie krijgt? Op die vraag promoveerde Mishra op 17 april aan de Radboud Universiteit in Nijmegen.

Een blik, in de wetenschappelijke literatuur gaze genoemd, bestaat uit een combinatie van oog- en hoofdbewegingen. In een gesprek wendt iemand vaak even zijn hoofd af. Een robot die dat niet doet komt over als een starende gesprekspartner, hoogst ongemakkelijk. Terwijl sociale robots juist bedoeld zijn om contact te maken met mensen. „Een robot is een sociale robot als de bedoeling is dat mensen ermee interacteren”, zegt Mishra. „Hij hoeft er niet uit te zien als een mens, het gaat er vooral om dat hij wordt geacht mee te doen met de sociale normen.”

Een robot leert dit uit data van menselijke conversaties. „We weten bijvoorbeeld dat iemands blik al zo’n 1.000 milliseconden eerder naar het voorwerp gaat dan dat hij het woord ervan uitspreekt”, zegt Mishra. „En dat ik als gesprekspartner 200 milliseconden na het uitspreken ernaar kijk. Met behulp van een deep learning model leert de robot dit soort patronen, zodat hij deze kennis ook in nieuwe situaties kan toepassen. In de robot draaien heel veel van dit soort modellen tegelijkertijd. Heel basaal herkennen of er een mens aanwezig is, is er ook al een.”

Verzot op computers

Als kind was Mishra nog geen robotgek. Hij was vooral verzot op computers, en ging dus computerwetenschappen studeren. Hij wilde ook graag over AI leren, maar dat vak werd niet aangeboden aan zijn Indiase universiteit. Na drie jaar werken als IT-consultant kreeg hij de kans om alsnog AI te studeren, in Duitsland. Pas toen hij voor een vak in een roboticalab kwam, sprong de vonk over. „Daar werkten ze met de voorloper van Ameca, de robot die ook in de film I, Robot met Will Smith wordt gebruikt. Het is een full body robot, met een gezicht dat ook emotie kan uitdrukken. Toen was ik gegrepen.”

De timing bleek goed. Robotica en AI zijn de laatste jaren booming, mede dankzij de opkomst van large language models (LLM’s), het type computermodel dat ook achter chatbot ChatGPT zit. Hierdoor zijn robots snel taal- en begripsvaardiger geworden. „Ik had geluk dat dit tijdens mijn PhD gebeurde”, zegt Mishra. „Eerder waren robotica-modellen meer gericht op de specifieke robots waarvoor ze ontwikkeld zijn. Dankzij LLM’s is wat we maken meer universeel toepasbaar. Mijn doel is altijd geweest om dingen te maken die voor iedereen te gebruiken zijn.”

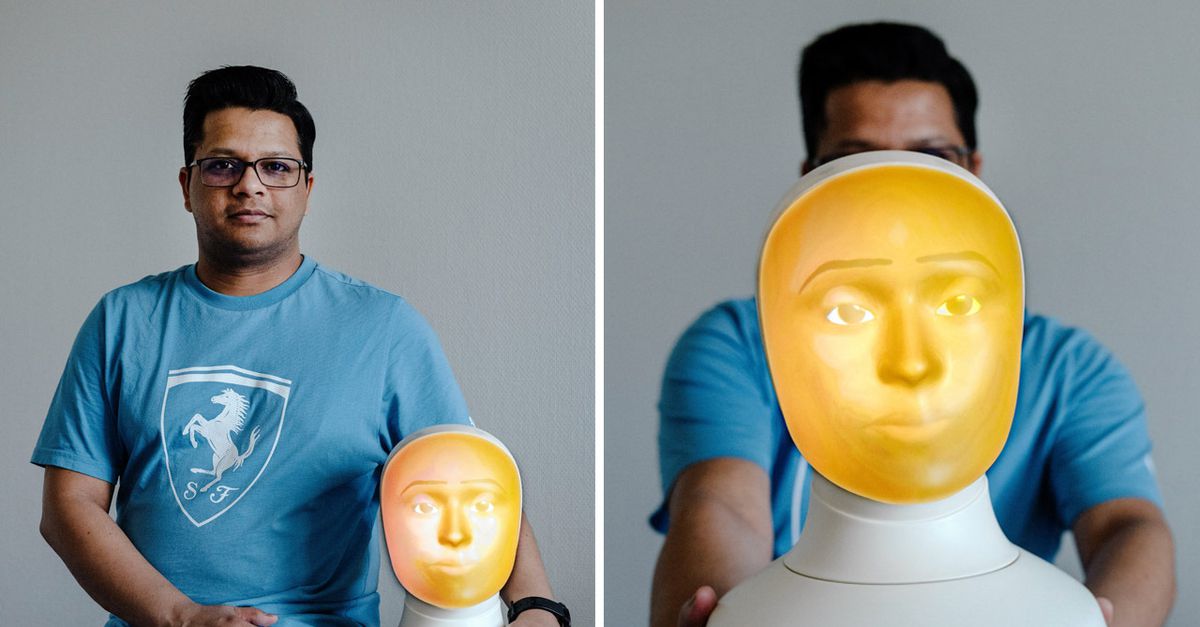

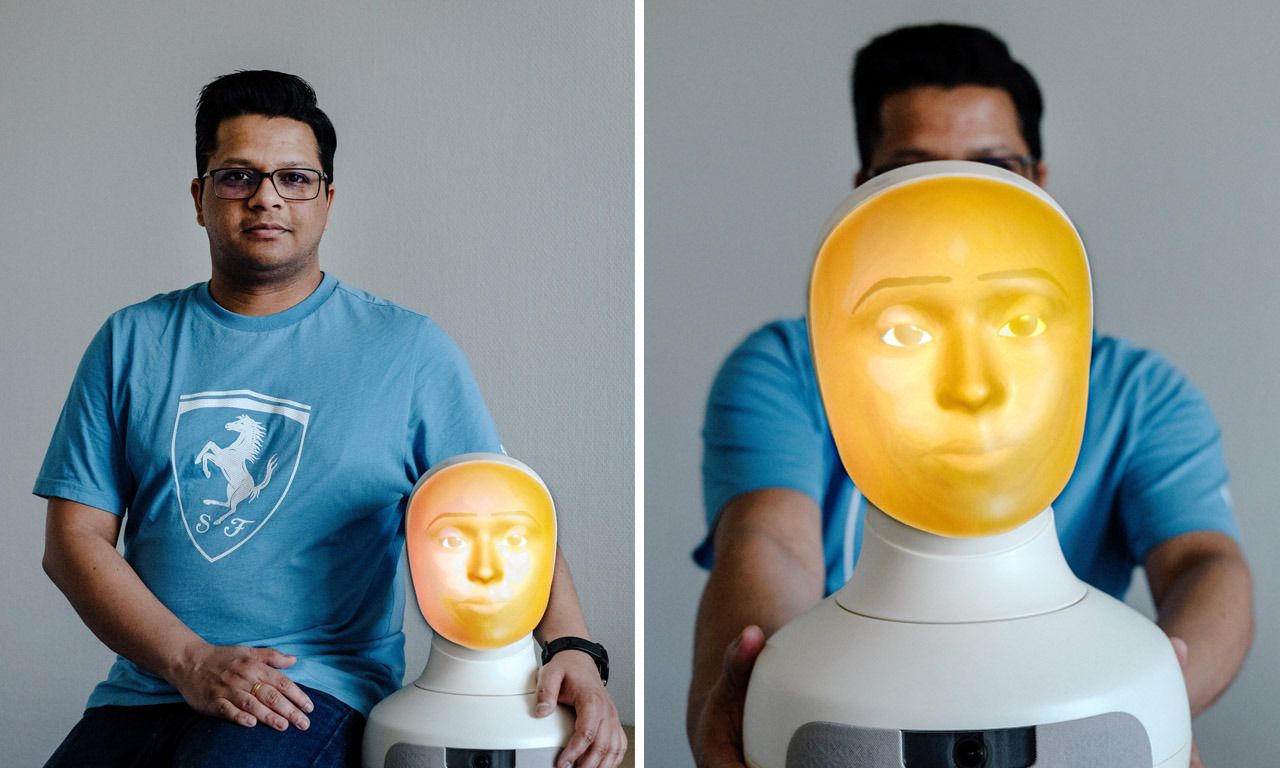

De robot waarmee Mishra tijdens zijn promotie werkte, genaamd Furhat, heeft alleen een hoofd. Vanaf de achterkant is een gezicht geprojecteerd, waardoor hij genuanceerde uitdrukkingen kan hebben. Om te onderzoeken of de communicatie levensecht aanvoelt speelde het Furhat een kaartspel met twee mensen. „Op een touchscreen waren vijf kaarten met afbeeldingen te zien”, zegt Misha. „Een vraag kon zijn: je moet in de woestijn overleven, sorteer de vijf afbeeldingen op volgorde van nuttigheid. Daarover discussieerden de drie gesprekspartners.” Inderdaad verliep de interactie soepeler als de robot ook ‘menselijke’ blikken wierp.

Dat effect bereikte hij niet in één keer. „We hebben eerst heel vaak zelf voor proefpersoon gespeeld, pas toen het voor ons natuurlijk aanvoelde gingen we echt testen”, zegt Mishra. „We liepen ook tegen praktische dingen aan. Als uit de data komt dat de robot binnen 200 milliseconden ergens naar moet kijken, dan moet het mechaniek van de robot dat natuurlijk wel kunnen.”

Uitdrukken van emoties

Het tweede deel van Mishra’s onderzoek richtte zich op het uitdrukken van emoties. Dat dit de vragen zijn die de wetenschap nu aan het beantwoorden is, doet vermoeden dat het niet lang meer duurt voor sociale robots in de samenleving opduiken. „Er wordt zo vaak geroepen ‘over vijf jaar is het zo ver’”, zegt Misha. „Ik kan het niet voorspellen. Je ziet nu wel allerlei bedrijven die bezig zijn met prototypes, dus het gaat wel hard. Maar the devil is in the details, voor je ze echt gaat inzetten, in de zorg bijvoorbeeld, moet heel goed onderzocht zijn dat het werkt zoals bedoeld.”

Mishra werkt nu als postdoc bij het Max Planck Instituut in Nijmegen. „Ik zou graag in de wetenschap blijven en onderzoek combineren met lesgeven. Ik hoop dat ik de kans krijg om dat te doen in India, zodat ook daar meer studenten in aanraking kunnen komen met AI en robotica.”

:format(jpeg):fill(f8f8f8,true)/s3/static.nrc.nl/images/gn4/data134742814-0a4290.png|https://images.nrc.nl/wRIzZwS8-yGgRdwFkJuRSSmldsc=/1920x/filters:no_upscale():format(jpeg):fill(f8f8f8,true)/s3/static.nrc.nl/images/gn4/data134742814-0a4290.png|https://images.nrc.nl/vka1akOdWVoO87BIodKDSF06Eg4=/5760x/filters:no_upscale():format(jpeg):fill(f8f8f8,true)/s3/static.nrc.nl/images/gn4/data134742814-0a4290.png)

/s3/static.nrc.nl/images/gn4/stripped/data134752425-53ab06.jpg|https://images.nrc.nl/GFofl0k5afa4cXzd2Oz9DYtSNlg=/1920x/filters:no_upscale()/s3/static.nrc.nl/images/gn4/stripped/data134752425-53ab06.jpg|https://images.nrc.nl/1ZfvCyTHDMkU_mogc76vyF4Hk2Q=/5760x/filters:no_upscale()/s3/static.nrc.nl/images/gn4/stripped/data134752425-53ab06.jpg)

/s3/static.nrc.nl/images/gn4/stripped/data134752482-c3b7cf.jpg|https://images.nrc.nl/RPYwCC4oluDnCtQHlan0YBFu1nE=/1920x/filters:no_upscale()/s3/static.nrc.nl/images/gn4/stripped/data134752482-c3b7cf.jpg|https://images.nrc.nl/BZz_GuoDzdXpWYEtjlMG05AlYfQ=/5760x/filters:no_upscale()/s3/static.nrc.nl/images/gn4/stripped/data134752482-c3b7cf.jpg)

/s3/static.nrc.nl/images/gn4/stripped/data134752403-c392ce.jpg|https://images.nrc.nl/jjmfwDUlSWSHaLVEr2VjpYBfIaQ=/1920x/filters:no_upscale()/s3/static.nrc.nl/images/gn4/stripped/data134752403-c392ce.jpg|https://images.nrc.nl/kISQMh1aI4PD1wIa3b8Ykd88z4g=/5760x/filters:no_upscale()/s3/static.nrc.nl/images/gn4/stripped/data134752403-c392ce.jpg)

/s3/static.nrc.nl/images/gn4/stripped/data134759005-d0a035.jpg|https://images.nrc.nl/cvxr6SdbDg_K0yHG08V7lrvfaUE=/1920x/filters:no_upscale()/s3/static.nrc.nl/images/gn4/stripped/data134759005-d0a035.jpg|https://images.nrc.nl/YhBY6UAu3IaoWWczLt40VOTGEkc=/5760x/filters:no_upscale()/s3/static.nrc.nl/images/gn4/stripped/data134759005-d0a035.jpg)