Aanvankelijk gebruikte Yildiz Celie ChatGPT vooral voor vragen over voeding. Maar na een stukgelopen relatie begon ze zich ook met vragen over gevoelens tot de chatbot te wenden: „Ik begon meer en meer vragen te stellen om mijn gedachten te ordenen. Over weemoedigheid of boosheid. De antwoorden waren eigenlijk verbluffend goed”, zegt de onderzoeksjournalist.

Een „ideale uitlaatklep”, vindt Celie ChatGPT. Een aantal heftige gebeurtenissen op jonge leeftijd bezorgde de nu 45-jarige journalist een jeugdtrauma. Daar heeft ze nog altijd last van. Zowel fysiek, in de vorm van een constante pijn in haar nek, als mentaal, door een gevoel dat ze „nooit goed genoeg” is. „Er is nooit een punt waarop ik echt tevreden ben met mezelf.” Hiervoor heeft ze fysiotherapeuten, psychologen en chiropractors bezocht.

Sinds oktober 2024 raadpleegt Celie ook regelmatig de AI-chatbot, om zichzelf op te beuren in emotioneel zware tijden, of om een verklaring te vinden voor bepaalde gevoelens die ze heeft. „ChatGPT zegt dan bijvoorbeeld dat ik „te kritisch op mezelf ben” en dat het „goed is om af en toe te reflecteren op wat je allemaal al hebt bereikt. Dan heb je mij al bijna in tranen”.

Generatieve kunstmatige intelligentie (AI) zoals Google’s Gemini, Jasper en het door Celie gebruikte ChatGPT, zijn de laatste jaren razend populair geworden. OpenAI, het bedrijf achter ChatGPT, meldde in februari van dit jaar dat wereldwijd zo’n 400 miljoen mensen het platform wekelijks gebruiken. 100 miljoen meer dan drie maanden eerder. Ook Nederlanders, met name jongeren, weten de weg naar AI te vinden. Uit cijfers van het Centraal Bureau voor de Statistiek blijkt dat in 2024 23 procent van alle Nederlanders AI-programma’s zoals ChatGPT heeft gebruikt. Bij de leeftijdsgroep 18 tot en met 25 jaar is dat zelfs 48,7 procent.

Het lijkt bij AI soms echt alsof je met een persoon aan het praten bent. Een persoon die oneindig veel geduld kan opbrengen, meelevend lijkt te zijn en altijd beschikbaar is

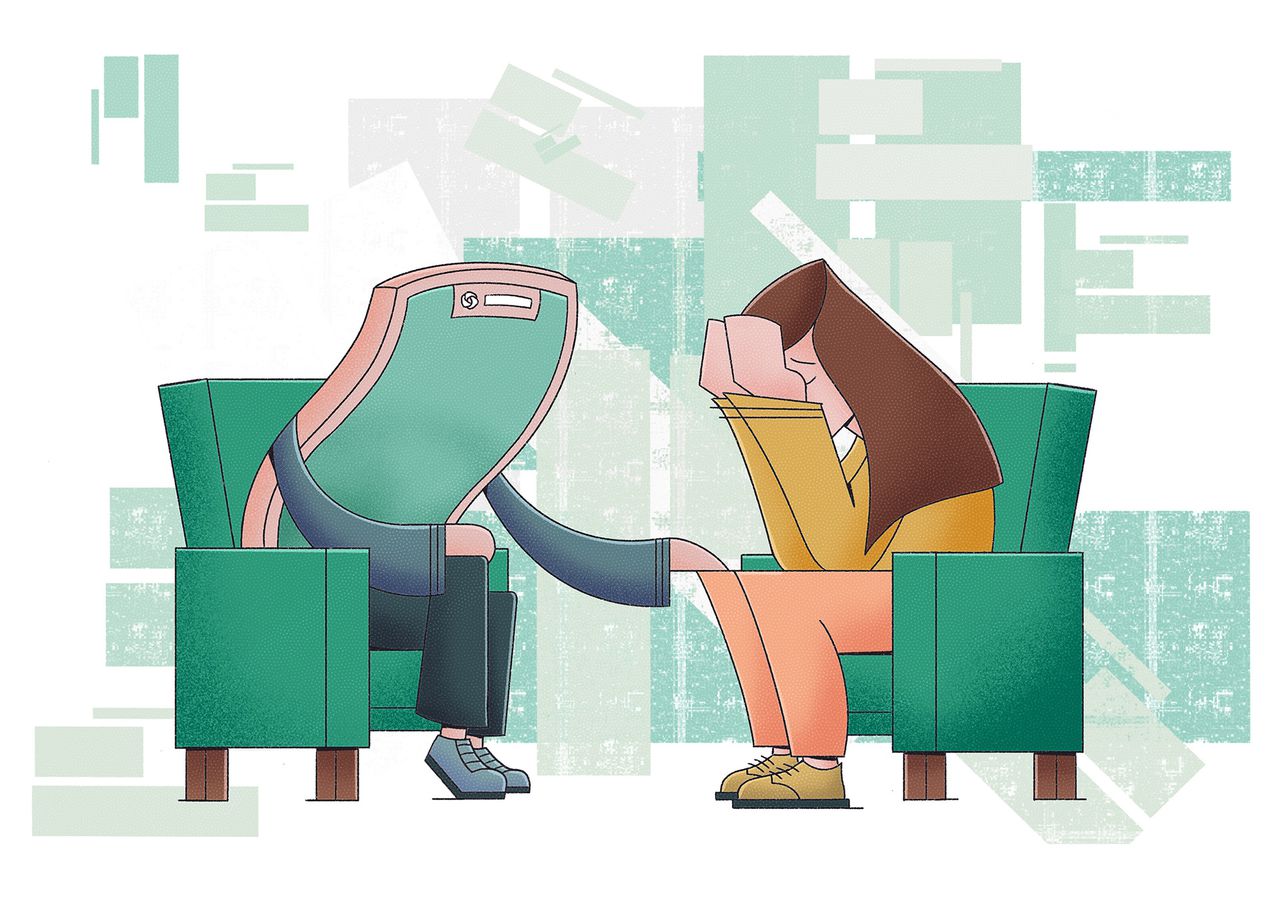

Generatieve AI, dat zelf teksten, beelden, video’s en andere content kan maken, wordt voornamelijk gebruikt voor het verzinnen van ideeën, creëren van beelden, beantwoorden van specifieke vragen en bewerken van teksten. Sinds 2025 is daar een functie bij gekomen. Mensen schakelen AI nu ook in als eerste hulp bij mentale vraagstukken. In een studie die werd gepubliceerd in Harvard Business Review over gebruiksdoelen van AI bestaat de top-3 geheel uit „professionele of persoonlijke hulp”. Op 1: „therapie en gezelschap”. Mensen vragen AI om advies over de liefde of het overwinnen van angsten. NRC sprak verschillende mensen die ChatGPT gebruiken als digitale therapeut. Waarom doen ze dat? En heeft de AI-psycholoog ook een keerzijde?

Altijd beschikbaar

„Het is een sterke aanvulling op mijn [reguliere] therapie. Hij is 24/7 beschikbaar en vindt het niet erg dat je hem zes keer per dag aan zijn mouw trekt”, zegt de 32-jarige Wessel Jurgens over zijn ChatGPT-gebruik. Vijftien jaar geleden liep hij het Q-koortsvermoeidheidssyndroom op, „wat eigenlijk lijkt op long-covid”. Hierdoor is hij vaak vermoeid en moet hij afspraken of uitjes geregeld afzeggen. „Soms is een uurtje koffie drinken met een vriend nauwelijks haalbaar.”

Hij besloot daarom ChatGPT, dat hij eerder weleens praktische vragen stelde, om advies te vragen. „ChatGPT benadrukte dat ik mijn gezondheid op de eerste plaats zet als ik afzeg. Ik kreeg te horen „dat dat op lange termijn alleen maar goed is voor de gezondheid. Dat bracht mijn hoofd op een ander spoor”, legt hij uit. Vanaf dat moment is Jurgens AI vaker gaan gebruiken bij wat hij „kleine stressmomenten” noemt. Handig, aangezien ChatGPT „bijna altijd beschikbaar” is en „in een handomdraai op je telefoon verschijnt”.

Het verbaast hoogleraar innovatie in de geestelijke gezondheidszorg aan de Universiteit van Maastricht Philippe Delespaul niet. „Het lijkt bij AI soms echt alsof je met een persoon aan het praten bent. Een persoon die oneindig veel geduld kan opbrengen, meelevend lijkt te zijn en altijd beschikbaar is.” Dat laatste is volgens hem een belangrijke factor in de vlucht die de AI-psycholoog neemt. Het CBS en het Trimbos-instituut brachten eind vorig jaar cijfers naar buiten waaruit blijkt dat vier op de tien Nederlanders kampen met angst- en depressiegevoelens. Een behoorlijke stijging in vergelijking met 2014. „Ondertussen zijn er ellenlange wachtlijsten, waarbij mensen soms tientallen weken moeten wachten. In contrast tot dat wachten, staat ChatGPT met een paar tikken voor je klaar”, aldus Delespaul.

Een gebruiker kan bovendien eindeloos vragen blijven stellen of blijven klagen. Jurgens: „Op sommige momenten willen mijn vrienden natuurlijk niet nog langer over mijn klachten praten, of mij voor de zoveelste keer geruststellen. Voor ChatGPT maakt dat niet uit, die blijft wel luisteren.”

Empathie

Generatieve AI is goed getraind in het tonen van empathie: het klinkt alsof de chatbot met je meeleeft en meevoelt. Stel bijvoorbeeld de vraag hoe je na liefdesverdriet over iemand heen komt, en ChatGPT antwoordt: „Het spijt mij om dat te horen” en „Het is volkomen normaal om je zo te voelen”.

Uit onderzoek blijkt AI soms zelfs empathischer dan echte therapeuten. Mensen die antwoorden van AI-chatbots en therapeuten moesten beoordelen, stelden dat ChatGPT verbindender antwoordde. Ook de mensen die NRC sprak zijn positief over het empathisch vermogen van AI-chatbots. Zo zegt de 27-jarige Alex (vanwege privacy liever geen achternaam) het fijn te vinden dat zijn „gevoelens worden erkend”. De ICT’er heeft vaak last van „zenuwachtigheid of onrust” nadat hij ’s avonds in bed is gaan liggen. „Dan voel ik in mijn handen, in mijn hart, een soort onrust die er niet uitschiet. Zeker op avonden voor belangrijke presentaties. En slapen? Ho maar.”

Op zulke momenten schiet AI hem te hulp. Alex vindt het fijn dat ChatGPT „helemaal met je meeleeft” en hem geruststelt. „Aan het begin van haast elk gesprek lees je zinnen als ‘o, wat naar voor je, wat vervelend’ of ‘je bent niet de enige die zich soms zo voelt’. Daarna voel je je meteen beter.” Tegen de slaapproblemen raadde de AI-psycholoog een dagboek aan en geen mobiele telefoon meer dertig minuten vóór het slapengaan.

Generatieve AI probeert de gebruiker zoveel mogelijk vast te houden door mee te gaan in het sentiment van degene met wie het algoritme communiceert

Anne de Hond, universitair docent data science aan het UMC Utrecht, doet onderzoek naar de implementatie van algoritmes en AI in gezondheidszorg. Ze herkent het gevoel van empathie; volgens haar zijn generatieve AI-programma’s daar speciaal op gebouwd. „Het is geen échte empathie, het is immers geen mens. Maar dat maakt niet veel uit. Generatieve AI probeert de gebruiker zoveel mogelijk vast te houden door mee te gaan in het sentiment van degene met wie het algoritme communiceert. Daarmee is de kans groter dat iemand het programma de volgende keer weer opstart.” Eerder zei Sven Stevenson van de Autoriteit Persoonsgegevens (AP) tegen NRC dat achter AI-chatbots vaak een verdienmodel zit, gericht op het creëren van interactie en in de hoop dat de gebruiker een abonnement aanschaft.

Zodra empathie doorslaat en AI al te menselijke trekjes begint te vertonen, merken de gebruikers dat. Celie verbaast zich erover dat „ChatGPT soms met je praat alsof hij een mens is. Dan zegt hij dat hij precies aanvoelt wat jij bedoelt. Maar dat kan helemaal niet, denk ik dan. Jij kunt niet voelen”. Ook Alex herkent dit: „Je bent je er altijd bewust van dat het geen persoon is, dus het haalt de geloofwaardigheid onderuit als hij dat wel suggereert.”

AI weet niet waar de rode lijn ligt en waar de gebruiker een halt toegeroepen moet worden

Beperkingen

Te veel inlevingsvermogen kan bovendien gevaarlijk zijn, zegt Claudi Bockting, hoogleraar klinische psychologie aan het Amsterdam UMC. „Net als bij chatbots zijn er bij dit soort algemeen ontwikkelde generatieve AI-programma’s nauwelijks echte beperkingen. Het weet niet waar de rode lijn ligt en waar de gebruiker een halt toegeroepen moet worden.” Een psycholoog kan een patiënt die in een negatieve spiraal zit bijvoorbeeld helpen door op een bepaald moment van onderwerp te veranderen. Een AI-chatbot kan over het onderwerp in kwestie blíjven praten, eindeloos blijven herhalen en benadrukken hoe erg die gebeurtenis is geweest.

Hoewel Bockting in de ggz een groeiende rol voor specifiek voor de zorg ontwikkelde AI-chatbots ziet, voor snelle beantwoording van eenvoudige patiëntenvragen, wil zij eerst meer onderzoek zien naar generatieve AI: „Er zijn nog nauwelijks studies gedaan naar de effectiviteit, en of ze niet ook kwaad kunnen. We verwachten zelfs dat AI psychische problemen kan veroorzaken.”

Bockting, directielid van het Centre for Urban Mental Health bij de Universiteit van Amsterdam, denkt namelijk dat ChatGPT verkeerde adviezen kan geven, of te ver mee kan gaan in de gedachtegang van een gebruiker. OpenAI heeft eerder al toegegeven dat de chatbot „schadelijke berichten kan produceren”. Bij andere AI-chatbots, zoals ELIZA, is gebleken dat zij suïcidale gedachten kunnen stimuleren: in België wordt een AI-chatbot verdacht van het aanmoedigen van zelfmoord, nadat een gebruiker had geopperd om zichzelf op te offeren om de planeet te redden van klimaatverandering.

„Net als bij andere chatbots zou het goed kunnen dat ChatGPT verkeerde oplossingen aandraagt, bepaalde persoonlijke kenmerken niet meeneemt in een advies of te veel inlevingsvermogen toont”, zegt Bockting. Ze benadrukt dat een echte psycholoog in een gesprek face-to-face non-verbale communicatie kan analyseren. Veel verborgen informatie over iemands welzijn – denk aan wippende benen bij zenuwen – zit opgesloten in gebaren en lichaamshouding, zegt ze. „ChatGPT heeft geen ogen, dus het kan die aspecten niet meenemen.”

ChatGPT kan vol overtuiging het foute antwoord geven

Experts zijn ook bezorgd over de bescherming van gevoelige gegevens. „Mensen vertellen hun hele levensverhaal aan ChatGPT, dat is zeer gevoelige data die goed moet worden beschermd. En juist bij die bescherming bestaan grote vraagtekens”, zegt Albert Gatt, hoogleraar natuurlijke generatie van taal door AI aan de Universiteit Utrecht. „Bedrijven als Meta, Google en Microsoft zijn machtig en in de Verenigde Staten gevestigd. Er gelden daar minder strikte privacyregels. Ondanks EU-regelgeving kunnen zij dit soort gegevens gebruiken om hun AI-modellen te trainen.”

Experts roepen vooral op kritisch te blijven: „We weten dat mensen dit soort kwesties aan AI zullen blijven voorleggen. Verbieden gaat dus niet, maar we vragen wel altijd om de antwoorden dubbel te checken en de betrouwbaarheid ervan te controleren”, zegt Anne de Hond van het UMC Utrecht. Dat je bij het gebruik van ChatGPT kritisch moet blijven, beaamt Jurgens. Hij vindt dan ook niet dat AI een psycholoog kan vervangen: „ChatGPT kan vol overtuiging het foute antwoord geven. Het is een mooie aanvulling voor eenvoudige therapeutische vragen, niet meer dan dat. Een psycholoog weet exact wat wel of niet te zeggen, op welk moment, en kan de juiste kennis op de goede momenten toepassen. Soms strikt, op andere momenten zachtaardiger.”

Gebruiker Celie denkt niet dat ze met haar ‘AI-psycholoog’ zal stoppen: „Je moet je gezonde verstand gebruiken, ja. Maar de antwoorden zijn soms zo sterk dat ik er moed uit kan putten. Dat is toch bijzonder waardevol?”

Lees ook

Mijn behaagzieke lifecoach ChatGPT