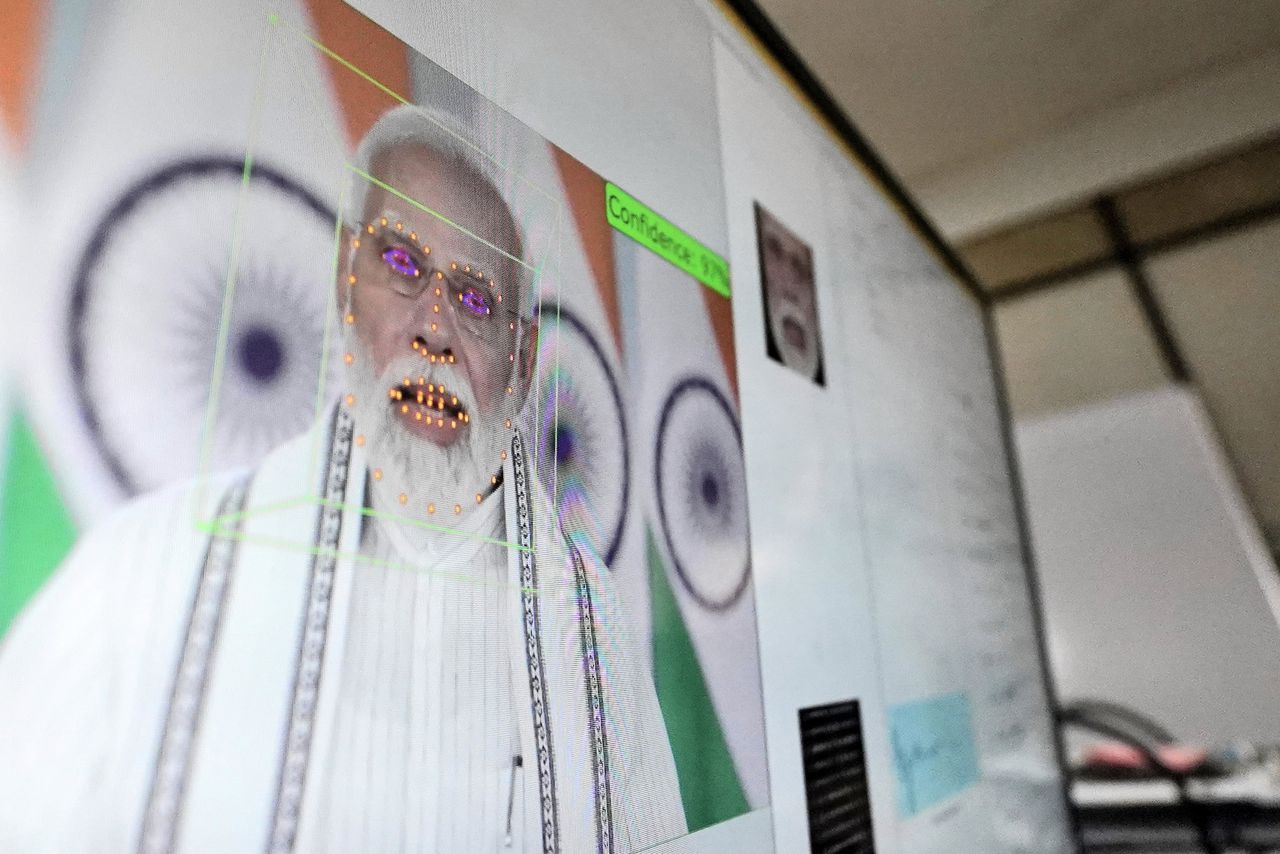

Het is al vaak gezegd en geschreven: 2024 is het jaar van de waarheid als het gaat om de invloed van kunstmatige intelligentie (AI) op verkiezingen. Meer dan honderd landen stemden of gaan nog stemmen dit jaar, waaronder de Verenigde Staten, India, Zuid-Afrika en Brazilië. Gevreesd werd voor een ‘AI-apocalyps’ waarbij met AI gemaakte of gemanipuleerde informatie de stembusgang kon gaan verstoren. Denk aan deepfakes: filmpjes waarin iemands stem en gezichtsbewegingen nagemaakt zijn. Zodat een politicus die iets zegt wat diegene nooit heeft gezegd – maar hem of haar wel stemmen kan kosten.

De impact van met AI gegenereerde beelden op verkiezingen valt vooralsnog mee, zeggen onderzoekers. Het misinformatie-aanbod is al verzadigd met zogeheten cheapfakes, beeldmateriaal dat met eenvoudige middelen is aangepast of uit de context getrokken. Deepfakes zien zij veel minder. Maar daarbij houden misinformatie-onderzoekers vaak de slag om de arm dat er vooral onderzoek is gedaan naar AI-fakes in westerse landen. „Er is minder data beschikbaar in andere landen, en we kunnen niet uitsluiten dat generatieve AI daar een groter negatief effect heeft”, schreven onderzoekers onlangs in de Harvard Misinformation Review bij hun conclusies dat AI-fakes in het westen nog geen grote invloed hebben.

Lees ook

Waarom de vloedgolf van AI-nepnieuws (vooralsnog) uitblijft: ‘Voor misleiden is AI niet nodig’

Nogal een dode hoek, want meer dan driekwart van de wereldbevolking woont niet in het Westen, maar in het mondiale Zuiden. En hoewel je Ecuador, Zuid-Afrika en Indonesië niet op één hoop kunt gooien, zijn er een paar overkoepelende factoren die onderzoekers doen vrezen voor de schade door AI-fakes in het mondiale Zuiden. Digitale- en mediawijsheid is er ongelijker verdeeld dan in het Westen en er zijn minder onafhankelijke media. Zo beredeneerd zou AI er in potentie sneller grote groepen mensen kunnen misleiden.

Stortvloed

In de aanloop naar de parlementsverkiezingen in India in april, werd dan ook gevreesd voor een stortvloed van AI-fakes. „India staat hoog op de lijstjes van landen die vatbaar zijn voor de negatieve invloed van misinformatie”, zegt de Indiase technologiejournalist Nilesh Christopher. Eerder hielden Facebook en Instagram met AI gemaakte advertenties die aanzetten tot geweld tegen moslims niet tegen. De advertenties waren bij wijze van stresstest ingediend door twee ngo’s. „Veel mensen hadden dus terecht zorgen over deze nieuwe vorm van synthetische inhoud die geïnjecteerd zou worden in het politieke discours.”

Toch stelde Christopher achteraf vast dat aan de meeste misinformatie rond de Indiase verkiezingen geen AI te pas was gekomen. „Het volume was veel kleiner dan dat van traditionele vormen van misinformatie.” Hij baseert zich mede op een rapport van de Indiase factcheckorganisatie Boom, dat voor de verkiezingen 258 factchecks uitvoerde. Daarvan ging het in minder dan 5 procent van de gevallen om deepfakes en andere AI-beelden, zoals een filmpje waarin de populaire acteur Aamir Khan premier Modi leek te bekritiseren. Veel vaker ging het niet om deepfakes, maar om oude beelden die in een misleidende context waren geplaatst. Zoals een foto waarop een Indiase politicus vlees zou eten op een feestdag waarop dat niet de bedoeling is. De foto was echt, maar het bijschrift verzonnen: het maal bestond uit onder andere geroosterde aubergine.

Ook toen Zuid-Afrika eind mei naar de stembus toog, gingen er deepfakes rond. Zoals een fragment waarin de beroemde Amerikaanse rapper Eminem Zuid-Afrikanen in een talkshow lijkt op te roepen om niet op regeringspartij ANC te stemmen, want „ANC fucked up”. Maar ook in Zuid-Afrika was de rol van AI in de misinformatiestroom beperkt. „Gezien alle media-aandacht en hype rond hyperrealistische AI, hadden we verwacht dat we een enorme toename zouden zien in misleidende AI-content. Dat is in grote lijnen niet uitgekomen”, vertelt Kirsten Cosser, factchecker in Johannesburg voor de ngo AfricaCheck. Ook niet in de landen waar AfricaCheck ook kantoren heeft: Senegal, Nigeria en Kenia.

„AI-gebruik is nog altijd erg beperkt vergeleken met traditionele misinformatie waarbij dingen uit de context worden getrokken. Waarom een deepfake maken wanneer je ook een bijschrift kunt veranderen?” De deepfakes die wel rondgingen, waren niet erg realistisch. Zo sprak de nep-Eminem robotachtig. Bij andere filmpjes stond het logo van de AI-software nog in beeld.

Positieve effecten

De grote aandacht in media en politiek voor deepfakes verraadt een denkfout, zegt Payal Arora, die zich als hoogleraar aan de Universiteit Utrecht verdiept in de invloed van AI in het mondiale Zuiden. „De veronderstelling is dat we voordat er AI was, konden geloven wat we zagen, omdat het authentiek was.” Maar zeker in landen waar (staats)propaganda en onbetrouwbare informatie meer de norm is dan onafhankelijke journalistiek, heeft die situatie nooit bestaan, zegt Arora. Wat dat betreft is AI niet zoveel nieuws onder de zon. „Ook met cheapfakes kun je een werkelijkheid creëren die niet echt is. Het is niet zo dat hoe geavanceerder technologie is, hoe ernstiger het probleem is.”

Sterker nog: generatieve AI heeft ook geeft burgers ook een bevrijdend wapen in handen. Zo verspreidden Iraanse activisten deepfakes van vrouwen zonder hijab, wat in het land verboden is. Dat is geen ‘nepnieuws’, maar appelleert volgens Arora juist „aan een diepere waarheid”. „Denk ook aan homoseksualiteit, wat in het grootste deel van de wereld verboden is. Als je dat audiovisueel wil normaliseren, kan synthetische inhoud daarbij helpen.”

AI leent zich ook voor politieke satire. Laat een autocraat in een deepfake een mal liedje zingen en opeens boezemt hij een stuk minder angst in. „In veel landen die we tot het mondiale Zuiden rekenen, zeker in onvrije regimes, is de populairste manier van je mening uiten om het expres vaag te houden, zodat het potentieel satire kan zijn. In het Westen zeggen mensen tijdens protesten op straat precies wat hun mening is. Elders kun je daarvoor in de gevangenis belanden.”

Satire is inderdaad „het gereedschap van de zwakkeren”, zegt Nilesh Christopher, de Indiase journalist, die ook stelt dat AI de politiek dichter bij burgers brengt. Zo kunnen Indiase politici met AI-stemklonen opeens lokale dialecten ‘spreken’ en zo meer kiezers bereiken. „Een ander verrassend geval uit Pakistan was dat van de gevangen gezette oppositieleider Imran Khan, die niet aan de verkiezingen mocht meedoen. Hij gaf handgeschreven briefjes aan zijn advocaten, waarna de tekst werd omgezet in AI-toespraken.”

Verbieden

Ondertussen proberen verschillende landen AI-nepbeelden in te dammen. Zuid-Korea verbood politieke deepfakes tijdelijk in aanloop naar de verkiezingen van april. Singapore overweegt hetzelfde te doen wanneer het volgend jaar een nieuw parlement kiest. De vraag is wat het motief is. Singapore voerde in 2019 al een wet in die ‘online valsheden’ verbood. Kabinetsleden kunnen sindsdien informatie laten corrigeren of verwijderen en hebben het daarbij vaak gemunt op boodschappen van oppositiepolitici. Ook in Nederland klinkt regelmatig de roep om een verbod op ‘nepnieuws’ en dan vooral deepfakes.

Zelfs als de intenties zuiver zijn, zijn dit soort verboden glad ijs, zegt Arora. „Menselijke communicatie is complex en je kunt maar tot op zekere hoogte zeggen of iets nep of echt is. Iets kan nep zijn, maar bewust, omdat het een grap is. Zinniger is inzicht geven: wie is de bron, wat is de context?”

Socialemediaplatforms als Facebook en TikTok proberen het te vermelden als iets AI is. Dat lukt lang niet altijd, wat mede samenhangt met culturele nuances. AI-detectiesoftware is vaak getraind met westerse inhoud, waardoor bijvoorbeeld met een accent gesproken Engels ten onrechte als AI kan worden aangemerkt. Zeker in India, met zijn honderden verschillende taten, een uitdaging, zegt Christopher. „Maar: in het afgelopen jaar zijn er enorme stappen gemaakt in het maken van detectiesoftware in lokale talen wereldwijd.”

Narratieven

Volgens Arora is het correct labelen van AI-inhoud niet zaligmakend. „Het is niet zo dat als mensen maar weten of iets echt is of niet, ze hun politieke voorkeuren gaan veranderen.” De mate waarin informatie overtuigt hangt sterk af van het vertrouwen in de afzender en diens intenties.

Dat fenomeen is universeel volgens Arora, en ze verwijst naar hoe de Amerikaanse presidentskandidaat Donald Trump onlangs op televisie zei dat migranten honden en katten uit de tuinen van hun buren plukken en verorberen. Natuurlijk een onzinverhaal en binnen enkele uren waren de factchecks bij Amerikaanse media niet te tellen. „Maar Trump-aanhangers hadden zoiets van: ‘Daar heb je ze weer, ze nemen Trump letterlijk, terwijl het hem natuurlijk gaat om de bredere context van immigranten die een vreemde cultuur met zich meebrengen’. Dát is voor hen het punt. Of het verhaal over die honden en katten klopt of niet, is ze om het even.”

Nilesh Christopher doet na zijn onderzoek in India nu aan Harvard onderzoek naar politieke deepfakes in de VS. „De les die India de VS leert is dat de vorm die we dachten dat AI-misinformatie zou aannemen, namelijk die van een realistische deepfake van een politicus, niet het primaire format is.” Meer dan overtuigen, is het overbrengen van een gevoel of een associatie het doel, stelt hij. Hij noemt het plaatje van Kamala Harris als communist dat onlangs werd verspreid door de radicaalrechtse techmiljardair Elon Musk. Duidelijk nep. Maar dat beeld van Harris met rode baret getooid met hamer en sikkel beklijft wel, en is een trigger voor latino’s die voor het communisme zijn gevlucht.

Of neem Geert Wilders, die met AI zijn gedroomde Nederland tot leven wekt middels idyllische dorpsgezichten vol tulpen en blonde mensen. Christopher omschrijft het als de metaforische kracht van AI. „In het mondiale Zuiden hebben we gezien dat dat de kant is die AI-beïnvloeding opgaat.”

/s3/static.nrc.nl/images/gn4/stripped/data134655703-dfd678.jpg|https://images.nrc.nl/5xKR_5XxXLSiMcQuGuqz8da_jtk=/1920x/filters:no_upscale()/s3/static.nrc.nl/images/gn4/stripped/data134655703-dfd678.jpg|https://images.nrc.nl/0vfM6pqMCcqdqt9WytvsgrxuakM=/5760x/filters:no_upscale()/s3/static.nrc.nl/images/gn4/stripped/data134655703-dfd678.jpg)