N.B. Het kan zijn dat elementen ontbreken aan deze printversie.

Autonome wapensystemen Tegen wapens die door kunstmatige intelligentie worden aangedreven, zonder laatste controle door een mens, is verzet. Er zijn ook warme voorstanders. Deze week spreken militairen, politici en anderen uit ruim zestig landen erover in Den Haag.

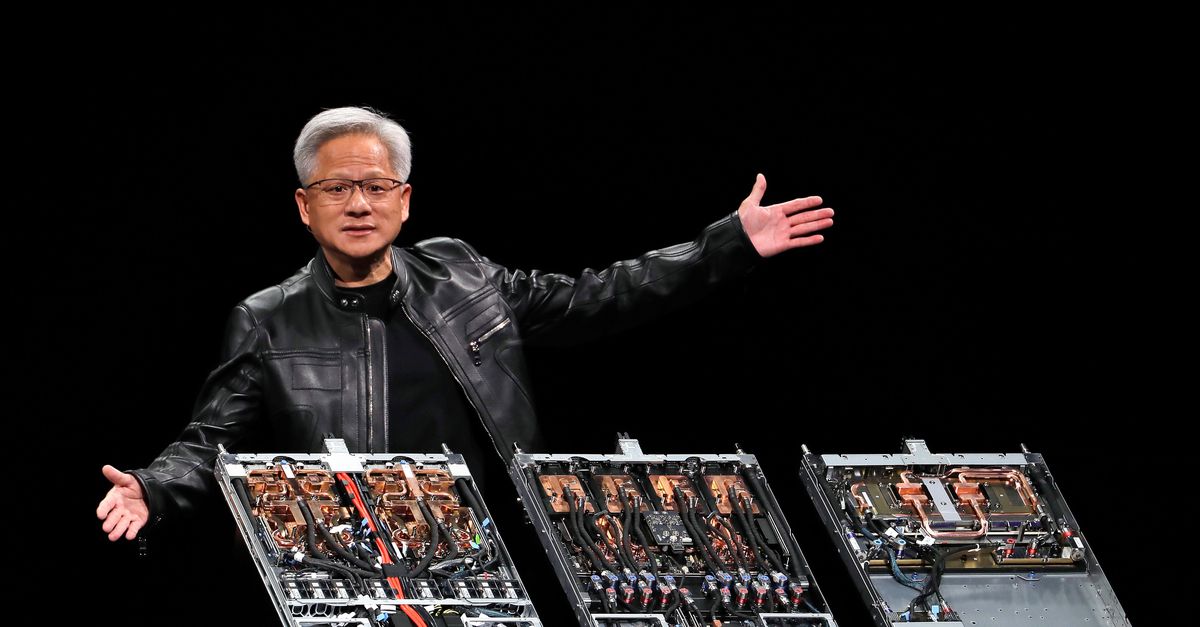

Foto Eyevine/ANP

Rusland test straks naar eigen zeggen het onbemande gevechtsvoertuig ‘Marker’ in de Oekraïense Donbas-regio. Bij hevige gevechten kan de robot-op-rupsbandjes de plaats innemen van menselijke militairen, met behulp van artificial intelligence (AI), ofwel kunstmatige intelligentie. Oekraïne zegt binnen een half jaar militaire operaties te kunnen uitvoeren met zwermen drones die ook door AI worden bestuurd.

Hoe geloofwaardig deze berichten zijn, is lastig te achterhalen in de zogeheten oorlogsmist. Dat rijdende en vliegende robots nu al zelfstandig kunnen vechten, vinden experts niet erg waarschijnlijk. Tegelijkertijd gaat de ontwikkeling van AI zo hard, dat onbemande voertuigen dit binnenkort naar verwachting wel kunnen.

Dat roept de vraag op hoe mensen controle kunnen houden over wapens die in staat zijn zelf doelen te selecteren en uit te schakelen. Door in elk geval de ontwikkeling van volledig autonome wapens te verbieden, zo luidt al jaren het pleidooi van vredesorganisaties en experts in internationaal recht. Door strak te reguleren zonder zo’n verbod, zeggen militairen en hun software-ontwikkelaars, want anders raken landen als Nederland achterop in de AI-wedloop met landen als Rusland, China en Iran.

Lees hier hoe autonome wapens juristen en vredesactivisten schrik aanjagen

Al deze stemmen zijn woensdag en donderdag te horen op de zogeheten REAIM-bijeenkomst, die wordt gehouden in Den Haag. Daar spreken op uitnodiging van Nederland en Zuid-Korea ruim tweeduizend wetenschappers, militairen, politici, ambtenaren, vredesactivisten en wapenfabrikanten uit meer dan zestig landen over verantwoordelijk gebruik van kunstmatige intelligentie door militairen.

Patroonherkenning

Nederland richt zich bij dat gebruik ook op de verdediging, zegt Peter Werkhoven, hoogleraar computerwetenschappen aan de Universiteit Utrecht en wetenschappelijk adviseur bij TNO: „Er worden bijvoorbeeld veel cyberaanvallen gepleegd op de computernetwerken in onze samenleving. De mens is niet in staat om in die stortvloed van enen en nullen een afwijkend patroon te zien en zo snel een aanval te detecteren. AI kan dat wel en kan ook in een fractie van een seconde bedenken wat de beste verdediging is.”

Patroonherkenning helpt ook inlichtingenofficieren, vertelt Pieter Elands van onderzoeksinstituut TNO dat veel samenwerkt met defensie: „Die moeten rapporten schrijven op basis van enorme hoeveelheden documenten die bevriende inlichtingendiensten en mensen in het veld aanleveren. Algoritmes die zijn getraind met natuurlijke taalmodellen kunnen in die teksten heel snel verbanden vinden.”

Vervolgens kijken de analisten of die verbanden ook echt wat betekenen, zegt Elands: „Want de techniek is nog niet perfect.” Zo is AI niet goed in het leggen van oorzakelijke verbanden, zegt Werkhoven: „Het is de mens die moet vaststellen hoe relevánt een verband is.”

Luchtafweer tegen drones of raketten kan eigenlijk alleen worden gestuurd door volledig autonome systemen

Pieter Elands, onderzoeker TNO

Bij de toepassing van kunstmatige intelligentie spelen dergelijke tekortkomingen militairen meer parten dan burgers. De zogeheten deep learning-modellen worden namelijk getraind door deze zeer omvangrijke dataverzamelingen te laten verwerken. „Het is heel moeilijk om 10 miljoen beelden van militaire voertuigen te krijgen. Honderd foto’s van een voertuig is al veel, zeker als je opnames vanuit de lucht wilt hebben. Dat maakt de patroonherkenning door AI op bepaalde plekken minder goed”, zegt Elands.

Mijnen en clustermunitie

Toch zal kunstmatige intelligentie steeds beter getraind raken. TNO werkt mee aan een defensieproject waarbij programma’s worden getraind met kleine datasets – de eerste resultaten zijn volgens Elands veelbelovend. De doorbraak van ChatGPT, de chatbot die verbluffend goed de menselijke taal blijkt te hanteren, laat zien hoe snel het gaat met AI. Meerdere onbemande vliegtoestellen van bijvoorbeeld Israëlische makelij zijn volgens vredesorganisatie Pax al bijna technisch in staat om helemaal zelfstandig te opereren.

Landen die het humanitair oorlogsrecht respecteren zijn het al een tijd erover eens dat de mens zodanig greep moet hebben op zulke wapensystemen, dat die bijvoorbeeld nooit burgers zullen aanvallen. Meaningfull human control wordt dat genoemd, zinvolle menselijke controle. Nederland heeft zich vorig jaar aangesloten bij de landen die dit in een verdrag willen regelen.

Lees hier over een verbod op volledige autonome wapens

‘Zinvolle menselijke controle’

Het grote discussiepunt is hoe die ‘zinvolle menselijke controle’ moet worden gerealiseerd. Met een verbod op wapensystemen die volledig autonoom opereren, zo vindt de Adviesraad voor Internationale Vraagstukken (AIV). Dat is ook wat vredesorganisaties als Pax willen. „Er moet een verdrag komen dat het gebruik van volledige autonome systemen verbiedt en andere autonome wapensystemen reguleert”, zegt Frank Slijper, directeur van Pax: „Net zoals dat is gebeurd voor het gebruik van landmijnen, die op personen zijn gericht, en voor de inzet van cluster-munitie.” Bij cluster-munitie vliegen na de inslag zoveel verschillende projectielen in het rond dat de kans groot is dat ook burgers worden geraakt. Een verbod heeft een remmende werking, al zullen niet alle landen zich er altijd aan houden.

Met een totaalverbod „doen we onszelf tekort”, vindt Elands. Bij TNO werken ze al lang aan manieren om ‘zinvolle menselijke controle’ in de praktijk te brengen, zonder dat de mens de hele tijd aan de knoppen zit. De luchtafweer tegen zwermen drones of raketten kan eigenlijk alleen worden aangestuurd door volledig autonome systemen. Vergelijk het met zelfrijdende auto’s, zegt Werkhoven: „In een panieksituatie moeten die in fracties van een seconde een keuze maken. Als de mens altijd het laatste besluit moet nemen, komen er geen volledig zelfrijdende auto’s.”

Het is dan wel noodzakelijk, zegt Elands „dat mensen hun ethische afwegingen expliciet maken en opleggen aan het systeem”. Werkhoven komt terug op de cyberaanval: „Stel dat in een fractie van een seconde een keuze gemaakt moet worden: houd ik een energiecentrale of een ziekenhuis overeind? Het morele afwegingskader moet de mens al vooraf hebben bepaald.”

Pax staat niet per se afwijzend tegenover volledig autonome systemen. „Zolang deze worden gebruikt met betekenisvolle menselijke controle. Onze zorgen gaan vooral over offensieve wapensystemen zonder die controle”, zegt Slijper, die aandringt op haast. Nederland wil graag een verdrag sluiten binnen de CCW, de Conventie over bepaalde conventionele wapens van de Verenigde Naties. „De CCW is prima om te praten over van alles en nog wat, maar neemt besluiten met consensus – alleen al door de tegenwerking van Rusland gaat een verdrag er dus niet komen”, zegt Slijper. „Dat zal buiten de CCW geregeld moeten worden. Want de technologische ontwikkelingen gaan zo snel.”