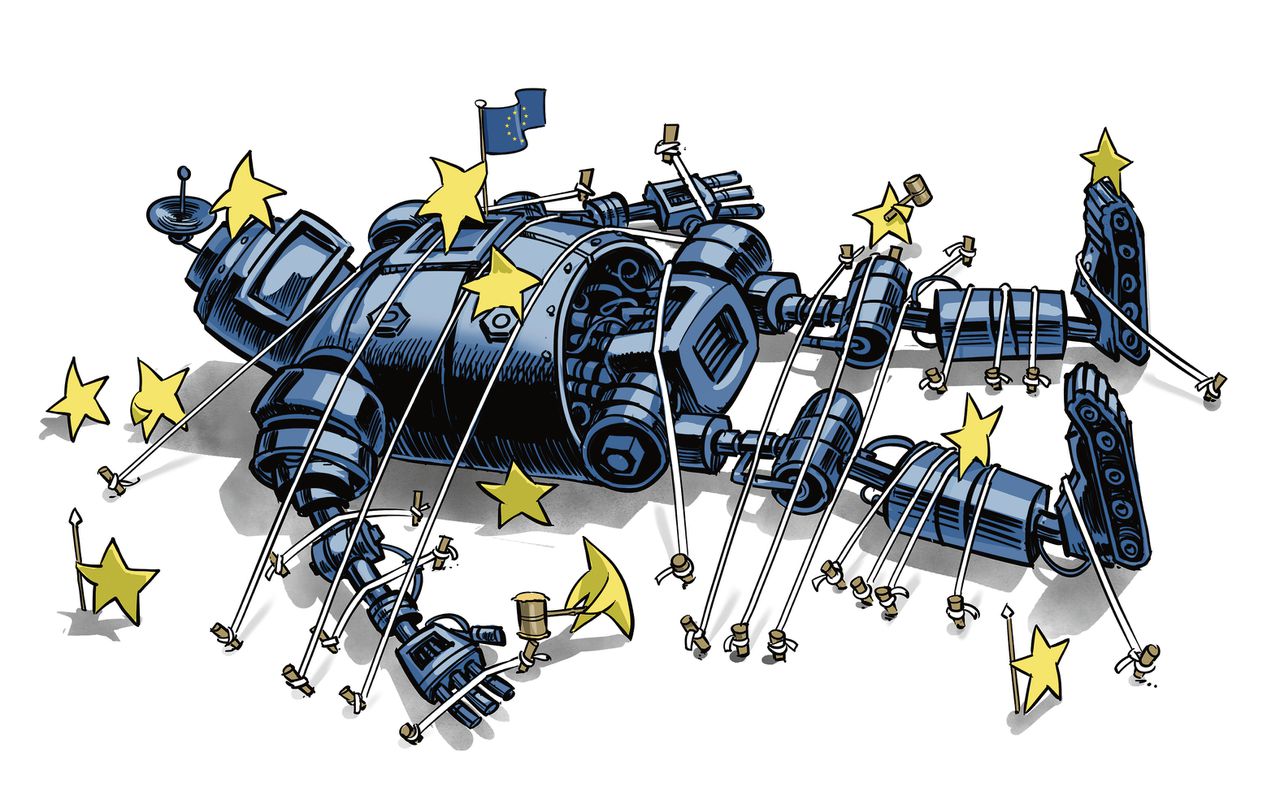

Aan de Europese AI Act ging een uiterst moeizaam traject vooraf. Van meet af aan was er de zware lobby van Amerikaanse techbedrijven als Microsoft en Google (de partijen achter ChatGPT en Bard/Gemini) die hun belangen op de Europese markt verdedigden. Op het laatste moment kwamen ook Duitse en Franse ontwikkelaars van krachtige AI-modellen, zoals Aleph Alpha en Mistral AI, met een wensenpakket. Hun nadruk op meer ruimte voor innovatie en zelfregulering deden de onderhandelingen over de nieuwe regels zelfs bijna ontsporen.

Een blik op het compromisvoorstel laat zien dat de Europese AI-aanbieders aan het langste eind hebben getrokken. Dat is wellicht goed nieuws voor Europese AI-innovatie. Tegelijkertijd heeft Brussel wel zijn oren laten hangen naar de techbedrijven. Ondanks waarschuwingen van kopstukken in de AI-sector en wetenschappers over de mogelijk verstrekkende gevolgen van kunstmatige intelligentie voor de samenleving, blijven onder het compromisvoorstel de meeste AI-modellen grotendeels ongereguleerd.

Dat is uiterst zorgelijk. Vooral omdat AI-innovatie de komende jaren over zoveel meer zal gaan dan de welbekende toepassingen van Amerikaanse techbedrijven als Microsoft en Google. De technologie zal tot in de haarvaten van onze samenleving doordringen. Zeker met de huidige arbeidstekorten kan AI op enorme belangstelling rekenen in het onderwijs, het justitiële domein, de zorg en sociale voorzieningen, media en tal van andere terreinen waar publieke waarden belangrijke pijlers zijn. Maar helaas staan instrumenten voor het beschermen van publieke waarden niet voorop in het uiteindelijke compromis.

Cyberveiligheid

De belangrijkste verplichting van de aanbieders van AI-toepassingen beperkt zich nu slechts tot het leveren van technische documentatie. Spijtig genoeg geven de afgesproken regels nauwelijks richting voor het beantwoorden van de vraag wanneer toepassingen van krachtige AI-modellen schadelijk kunnen zijn voor publieke waarden als het recht op non-discriminatie, bescherming van privacy, duurzaamheid of cyberveiligheid. Het is in principe aan de markt om ervoor te zorgen dat deze voldoende in acht worden genomen. Dat betekent dat media, opvoeders, academici, ambtenaren, advocaten en talloze andere eindgebruikers zélf de AI-toepassingen die zij van ontwikkelaars afnemen op deze waarden zullen moeten beoordelen. Degenen die worden onderworpen aan de toepassingen – burgers, consumenten, patiënten, leerlingen en anderen – kunnen vervolgens niet anders dan op deze beoordeling vertrouwen.

Natuurlijk zien ook wij dat er met AI veel moois valt te realiseren. Maar we moeten ons wel realiseren dat de uitkomst van de onderhandelingen over de Europese AI-wet veel gunstiger is voor de innovatiebelangen van producenten, dan voor de bescherming van burgers. Alleen de zeer krachtige AI-modellen zullen immers onder de nieuwe regels vallen, omdat ze een ‘hoog risico’ vormen voor de samenleving. Vreemd genoeg wordt ‘hoog risico’ gedefinieerd in termen van omvang (aantallen eindgebruikers) en computerrekenkracht die nodig is voor het trainen van deze modellen, en niet in termen van potentiële risico’s voor grondrechten, gezondheid en veiligheid. Kleinere AI-modellen blijven met deze nieuwe regels buiten schot.

Lees ook

Dit betekent de AI Act voor burgers: watermerk bij nepvideo, gezichtsherkenning onder strenge voorwaarden

Dit resulteert in de ironische situatie dat onder de EU AI Act een handvol Amerikaanse bedrijven ervoor moet zorgen dat hun systemen voldoen aan de Europese regels en waarden, terwijl Europese modellen zoals Mistral en Aleph Alpha grotendeels ongereguleerd blijven. Niet alleen omdat ze minder groot zijn dan hun mondiaal opererende concurrenten, maar ook omdat soepeler regels gaan gelden voor de opensourcemodellen waarvan zij gebruik maken – modellen waarvan iedereen de onderliggende technologie kan inzien en aanpassen.

Wij maken ons kortom zorgen over een mogelijke wildgroei aan applicaties die grotendeels ongereguleerd op de markt worden gebracht. Dat we zullen moeten vertrouwen op de redelijkheid van bedrijven als OpenAI, de welwillendheid van kleinere Europese spelers en het beoordelingsvermogen van afnemers in deze AI-markt, is ronduit verontrustend. Sinds het verschijnen van ChatGPT vorig jaar is de AI-geest voorgoed uit de fles en zal generatieve AI ons in alle sectoren van de samenleving beïnvloeden, ook in die sectoren die (nog) geen hoog risico vormen onder de AI-wet.

Wijsheid

Juist vanwege de teleurstellende Europese AI-wet zal de Nederlandse koers met betrekking tot generatieve AI nog belangrijker worden. Ons land wil een eigen AI-taalmodel bouwen (GPT-NL). Ook werkt de Nederlandse overheid aan een eigen visie op generatieve AI. Hopelijk heeft onze (nieuwe) regering de wijsheid om in ieder geval aanzienlijk te investeren in het weerbaar maken van onze samenleving.

De Nederlandse strategie moet gebruikers – professionals en amateurs – kortom in staat stellen voorwaarden op te leggen aan ontwikkelaars van AI-modellen. Bijvoorbeeld door te eisen dat fundamentele publieke waarden in hun beslissingen leidend zullen zijn: het waarborgen van mensenrechten en non-discriminatie, het maximaal inzetten op groene energie, het beschermen van onze democratie tegen massale door AI-gegenereerde desinformatie en het garanderen van rechten van eenieder die door AI-beslissingen in zijn of haar positie wordt geraakt.

Nu de Europese AI-wet het belang van de samenleving onvoldoende kan waarborgen, is het aan de Nederlandse overheid om zowel burgers als eindgebruikers in tal van maatschappelijke sectoren via duidelijk beleid de noodzakelijke steun te geven. Die steun is hard nodig nu in de wereld van AI-innovatie vooral grote financiële belangen prevaleren.

Leeslijst