N.B. Het kan zijn dat elementen ontbreken aan deze printversie.

Kunstmatige ofwel artificiële intelligentie (AI) is een term die we lang associeerden met sciencefictionfilms en futuristische robots. En toen kwam in november 2022 ChatGPT: een chatbot die hele gesprekken met je kan hebben en je op vele manieren kan helpen, gratis voor iedereen toegankelijk.

Met de nieuwe AI-modellen kun je teksten schrijven, nepfoto’s maken van bekende mensen, games programmeren of binnen een paar seconden een lijst met perfecte balkonplanten voor jouw flat opstellen. Opeens lijkt kunstmatige intelligentie een technologie die onze hele samenleving in de war kan gooien: raken we straks onze banen kwijt aan AI? Ofwel: moeten we bang zijn voor kunstmatige intelligentie?

Maar kunstmatige intelligentie biedt ook kansen. Wat kunnen we er zelf mee, en hoe werkt het als we aan ChatGPT vragen om iets te schrijven? Met deze gids poogt NRC de belangrijkste praktische vragen rond AI te beantwoorden. Dat blijft een proces: met nieuwe inzichten en toepassingen zal deze gids ook weer vernieuwd worden. Maar hopelijk biedt die voor nu sowieso alvast een handvat om deze complexe, veelomvattende technologie beter te plaatsen, te begrijpen, en te gebruiken.

Hoe werkt AI?

1 Wat is kunstmatige intelligentie?

Kunstmatige of artificiële intelligentie (AI) is in brede zin: een intelligent systeem dat door mensen ontworpen is. Maar over wat ‘intelligentie’ precies betekent, zijn de meningen verdeeld. Is een schaakcomputer die heel goed kan schaken intelligent? Of juist dom, omdat-ie verder niks anders kan?

In de praktijk wordt er doorgaans over AI gesproken als het gaat om systemen waarbij een computer min of meer zelfstandig data kan analyseren en tot conclusies kan komen op basis van die data. In feite zijn de algoritmen die sociale mediaplatformen gebruiken om te beslissen welke berichten jij ziet ook al rudimentaire kunstmatige intelligentie. Ze analyseren zelfstandig berichten en bepalen waar de gevonden video’s of teksten over gaan. Daarna besluiten ze welke berichten de scroller waarschijnlijk zal willen zien, op basis van een complexe rekenkundige formule.

Vaak wordt een deel van deze formule nog handmatig door een mens bedacht en bepaald, maar zogenoemde ‘machine learning’-systemen worden daarbij steeds belangrijker. Deze systemen ‘leren’ zichzelf aan welke formules ze moeten toepassen.

2 Hoe maak je een AI?

Er zijn verschillende manieren om kunstmatige intelligentie te ontwikkelen. Op dit moment is machine learning de meest prominente: hierbij wordt een computersysteem zo opgezet dat het patronen ‘leert’ te vinden in grote hoeveelheden data en op basis daarvan nieuwe data kan verwerken of aanmaken.

Dat begint met een trainingsfase, waarbij het systeem veel informatie krijgt om te bestuderen. Denk bijvoorbeeld aan vogelfoto’s uit een beeldbank, met bijbehorende namen. Bij het ‘zien’ van elke foto stelt het systeem zichzelf bij: komt dit stukje beeld vaker voor? Waar wordt het mee geassocieerd? Is er een naam voor? Uiteindelijk levert dit een model op, een programma dat vogels op nieuwe foto’s kan herkennen. Aan dat model kunnen mensen dan weer vragen stellen over hun eigen foto’s.

3Wat is generatieve AI en hoe werkt het?

Simpel gezegd is een generatieve AI een programma dat niet alleen beelden of teksten kan herkennen, maar ook zelf nieuwe beelden en/of teksten kan aanmaken. Denk aan chatbots als ChatGPT of Bard, maar ook aan beeldmodellen als Midjourney of Dall-E. In het geval van AI die zelf teksten maakt, spreken we doorgaans van Large Language Models (LLM), een bepaalde vorm van generatieve intelligentie die getraind is op een grote database met teksten.

Het gaat in alle gevallen om artificiële intelligentie die geleerd heeft om patronen te herkennen en te reproduceren. Denk aan hoe je telefoon kan ‘voorspellen’ welk woord jij aan het tikken bent: dat kan omdat de software weet welke letters het meest frequent volgen op de letters die jij al hebt ingevoerd. Een taal- of beeldmodel doet in feite hetzelfde, alleen heeft die veel meer bronmateriaal en kan het daarom accurater voorspellingen doen.

Hoe die trainingen precies plaatsvinden, is complex. Het kost veel energie en de koeling van betrokken computers vereist veel watergebruik. Een populaire leertechniek voor beeldmodellen is diffusie. Dat houdt in dat het systeem een afbeelding vervaagt totdat er alleen een wolk van verkleurde pixels ontstaat. Daarna probeert het systeem deze wolk weer terug te veranderen in de oude afbeelding. Daaruit kan het systeem leren hoe logisch het is dat een bepaalde pixel naast een andere pixel staat.

4Waarmee wordt generatieve AI getraind?

Om zo’n netwerk te trainen is ongelooflijk veel materiaal nodig, anders kunnen de nodige verbindingen niet gelegd worden. Maar wat voor materiaal er precies achter taalmodellen als ChatGPT zit, is lastig te beoordelen.

Voor ChatGPT waren miljarden woorden nodig. Daarom gebruikte eigenaar OpenAI waarschijnlijk onder andere de zogenoemde ‘Common Crawl’-database. Dit is een enorme verzameling van webpagina’s en boeken die sinds 2018 online beschikbaar zijn. De database is door iedereen gratis te downloaden. Maar Common Crawl is vooral berekend op wetenschappelijk onderzoek en ander niet-commercieel gebruik: er zit veel auteursrechtelijk beschermd materiaal in. Het is niet duidelijk of daar iets van verwijderd is bij het trainen van het taalmodel. En daarnaast heeft OpenAI waarschijnlijk nog veel meer data gebruikt, waarvan we weinig afweten.

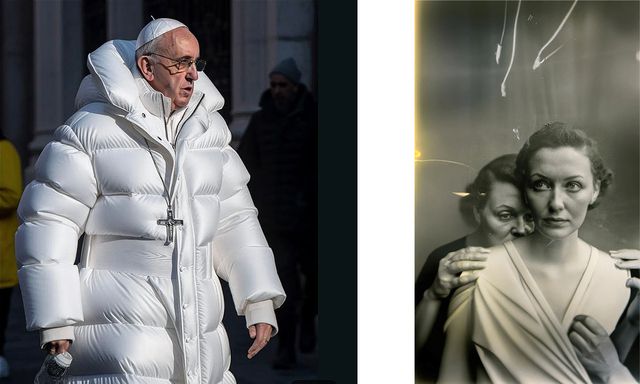

Bij beeldmodellen leidt dit nu al tot controverse. Zo wordt Stability AI, het bedrijf achter beeldmodel Stable Diffusion, aangeklaagd door Getty Images omdat het watermerk van Getty duidelijk op gegenereerde beelden te zien is. Daarom weet Getty zeker dat Stability AI ook beschermd materiaal uit de Getty-beeldbank heeft gebruikt om het model te trainen.

5 Hoe lang bestaat AI?

De mensheid dagdroomt al heel lang over het bouwen van apparaten die zelf kunnen denken. Denk maar aan Frankenstein van Mary Shelley, dat in 1818 gepubliceerd werd (en in 1931 verfilmd): een wetenschapper bouwt een zelfbewust wezen uit dode lichaamsdelen.

De eerste concrete stappen naar een kunstmatig intelligente computer werden zo rond de jaren vijftig van de vorige eeuw gemaakt. De Britse computerkundige Arthur Samuel bouwde in 1952 het eerste programma dat kon dammen. Slechts drie jaar later werd de uitdrukking ‘artificiële intelligentie’ voor het eerst openbaar gebruikt. Maar pas toen de Deep Blue-schaakcomputer in 1996 schaakkampioen Garry Kasparov wist te verslaan, kwam AI echt in de publieke belangstelling te staan.

Lees ook dit artikel over Deep Blue uit ons archief: Voor ‘Deep Blue’ is schaken maar bijzaak

6 Welke bedrijven werken nu aan AI?

Heel Silicon Valley staat inmiddels bol van de kleine en grote techbedrijven die ‘iets’ met artificiële intelligentie willen doen. Ze zetten veel in op generatieve AI, omdat dat vrij breed inzetbaar is. De meeste bedrijven werken daarbij met andermans beeld- of taalmodel. Wie de middelen heeft om er zelf een samen te stellen, heeft dus potentieel veel macht.

Van die partijen maakte OpenAI de meeste furore, nadat de organisatie vorig jaar taalmodel ChatGPT en beeldmodel Dall-E beschikbaar stelden aan het grote publiek. Dit bedrijf begon als een non-profitstichting, opgericht door miljardairs als Elon Musk (Tesla), Peter Thiel (PayPal) en Sam Altman, maar werd door de jaren heen steeds commerciëler. Microsoft investeerde miljarden dollars in OpenAI en maakt gebruik van ChatGPT voor de AI-versie van zijn Bing-zoekmachine.

Een aantal grote techbedrijven werkt aan, of heeft al, taalmodellen die op GPT lijken. Google heeft net een eigen chatbot gelanceerd: Bard, op basis van zijn GPT-concurrent LaMDA. De Chinese zoekmachine Baidu heeft een eigen chatbot, ERNIE. Meta, het moederbedrijf van Facebook, werkt aan zijn LLaMa-model. LLaMa is open source, wat betekent dat anderen de technologie kunnen inzien en gebruiken om hun eigen taalmodellen te trainen.

De Chinese techgigant Alibaba kondigde in april Tongyi Qianwen aan, kunstmatige intelligentie die onderdeel wordt van zijn zakelijke chatplatform. Daarnaast werken ook kleinere bedrijven als hardwarefabrikant Nvidia aan eigen taalmodellen. Stable Diffusion en Midjourney zijn de voornaamste beeldmodellen en in handen van onafhankelijke bedrijven.

7 Hoe gebruikt NRC AI?

NRC maakt op de redactie ook gebruik van kunstmatige intelligentie. „Zo gebruiken onze journalisten sinds dit jaar een transcriptietool om hun opnames uit te werken gebaseerd op Whisper, de spraakherkenningstechnologie van Open AI”, zegt adjunct-hoofdredacteur Melle Garschagen. „Dit is een toepassing van kunstmatige intelligentie die onze journalisten veel tijd scheelt en waardoor ze zich beter kunnen richten op waar hun meerwaarde ligt: mensen spreken, onderwerpen uitdiepen, zaken uitzoeken.”

Ook worden alle artikelen die NRC op een dag publiceert (circa 80) sinds dit jaar voorgelezen door computerstemmen. Daarvoor zijn de stemmen van NRC-redacteuren Mischa Spel en Egbert Kalse gebruikt. „Zij hebben ongeveer zestien uur lang teksten ingesproken en op basis van AI is dat voldoende om alle NRC-journalistiek voor te laten lezen”, zegt Garschagen. „Dit is een manier om kunstmatige intelligentie toe te passen om het gemakkelijker te maken voor onze abonnees om onze journalistiek tot zich te nemen.” Benieuwd? Luister dan ook deze AI-gids met een druk op de ‘luister naar’-knop.

De ontwikkeling van kunstmatige intelligentie zal de komende jaren „stormachtig zijn”. Dat brengt risico’s met zich mee voor de betrouwbaarheid en de controleerbaarheid van de journalistiek. Maar volgens Garschagen behelst dat ook kansen om „grensverleggend te vernieuwen”. „Op de redactie gaan we daarmee aan de slag. Wat mij betreft zijn belangrijke stelregels: als we AI-toepassingen gebruiken zijn we daar transparant over. En hoe we AI ook inzetten, het principe van a human in the loop is cruciaal. Bij NRC blijft een mens van vlees en bloed verantwoordelijk voor onze journalistiek.”

Wat kan ik met AI?

1 Welke rol speelt AI nu al in mijn leven?

Met de komst van ChatGPT staat artificiële intelligentie opeens hoog op de agenda, maar in de afgelopen jaren zijn bedrijven en overheden er al steeds meer gebruik van gaan maken. Denk aan artsen die jouw scans laten evalueren door een systeem dat getraind is om borstkanker te herkennen, maar ook aan onderwijssoftware die jouw leraar helpt om het huiswerk van de kinderen sneller na te kijken door alvast een analyse vooraf te doen.

Omdat artificiële intelligentie zo goed is in patronen herkennen, wordt AI ook ingezet om voorspellingen te doen. Bijvoorbeeld bij diagnoses dus, maar verzekeraars experimenteren ook met AI om risicovoorspellingen te doen. Er wordt nagedacht en gewerkt met AI-fraudedetectiesoftware.

Waarschijnlijk heb je dagelijks of zelfs elk uur wel een paar keer met een proces te maken dat op één of andere wijze raakt aan AI – en dat is nog zónder de manier waarop ChatGPT nu wordt ingezet. Bijvoorbeeld als je bij de dokter zit, maar ook wanneer je je gezicht scant om je smartphone te ontgrendelen, je boodschappen scant bij de supermarkt, door je timeline scrollt op TikTok of aan de stemassistent vraagt om een liedje op te zetten.

2 Hoe werk ik met een taal- of beeldmodel?

Taal- en beeldmodellen zijn slimmer dan de algoritmen van vroeger, maar ze zijn nog altijd bijzonder letterlijk. Daarom zijn gebruikers van ChatGPT nu op zoek naar de beste manier om te ‘prompten’: een vraag voor ChatGPT of een ander taal- of beeldmodel zo formuleren dat het juiste antwoord eruit rolt. Wat er standaard uitrolt, is vaak niet bepaald origineel: het is nu eenmaal gebaseerd op de meest voorkomende patronen in de trainingsdata.

In de praktijk betekent dat doorgaans: kaders stellen. Als je wil dat ChatGPT je essay beoordeelt alsof de chatbot je docent is, dan moet je ChatGPT vragen om zich in te beelden dat hij docent is, en leg je het taalmodel idealiter ook voor waar de docent vermoedelijk op zal letten. Beschrijf meteen de vorm die je wil: bulletpoints, een diepe bespreking, of iets dat kort en krachtig is?

Overigens is ChatGPT geen zoekmachine of vraagbaak. De intelligentie is notoir onbetrouwbaar: het kan zomaar een paar willekeurige woorden achter elkaar zetten als het geen echt, feitelijk antwoord voor je heeft. Je hebt dus meer aan ChatGPT als die bestaande tekst beoordeelt of herschrijft, dan wanneer je het taalmodel vraagt om een geheel nieuwe tekst te maken, zonder eerst de relevante informatie zelf te verstrekken. Al kan het taalmodel je ook vertellen welke vragen het meest gesteld worden over een onderwerp.

3 Hoe herken ik AI-teksten en -beelden?

Met de komst van gemakkelijk te gebruiken taal- en beeldmodellen volgt ook het risico op nepbeelden en -teksten die als echt worden aangeboden. Voor ChatGPT-teksten en aanverwanten is er herkenningssoftware, zoals GPTZero. Maar deze software blijkt net zo onbetrouwbaar als ChatGPT zelf. Daarom heeft OpenAI zijn eigen ‘herkenner’ weer offline gehaald.

Je kan er ook op letten of een tekst algemeen klinkt, niet-bestaande feiten opdreunt of een vlakke toon aanhoudt, maar ook dat is niet per se een betrouwbare methode: mensen klinken ook wel eens vlak, en je kan ChatGPT vragen een bepaalde stijl aan te houden. Een heel goede techniek is er dus helaas nog niet.

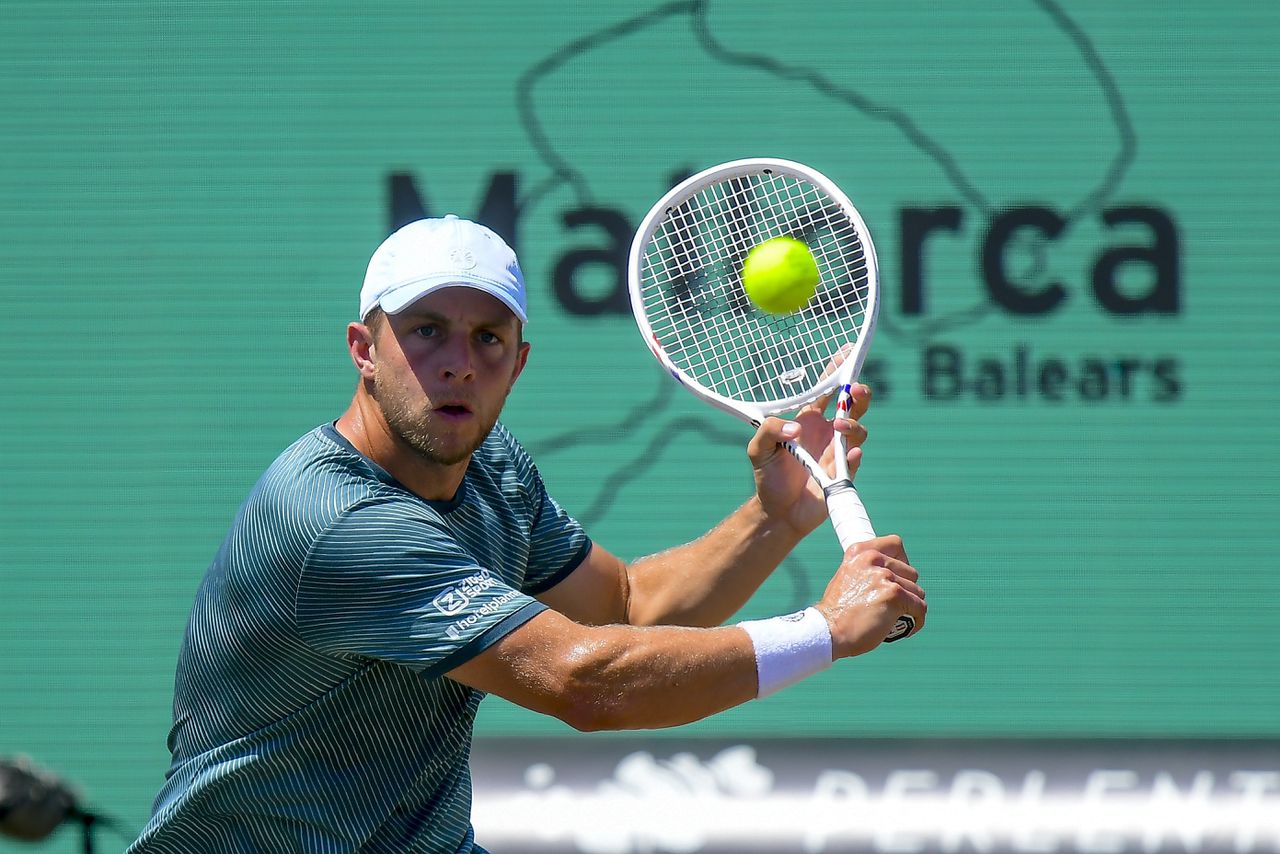

Wil je weten of beeld door AI is gemaakt? Daarvoor droeg Eliot Higgins, oprichter van onderzoeksjournalistieknetwerk Bellingcat, deze acht fouten aan die beeld-AI vaak maakt:

4 Hoe gaan artsen om met AI?

Op allerlei manieren. Het begint al bij de huisarts. Het systeem NHGDoc kan je arts namelijk advies geven over de aanpak van jouw probleem door patiëntendossiers en behandelrichtlijnen te vergelijken. AI kijkt in sommige ziekenhuizen mee bij een colonoscopie om verdachte poliepen te vinden, of zoekt naar bloedpropjes op de longen op een CT-scan. AI is hier heel goed in, vaak zelfs beter dan artsen: het gaat immers om het zoeken en herkennen van bekende patronen.

Eigenlijk kan AI al bijna op elk punt in het medische proces ingezet worden, en waar dat niet mogelijk is, wordt onderzoek gedaan naar manieren om AI tóch toe te passen. Zo testen de onderzoekers in Utrecht momenteel een algoritme dat moet helpen om de reactie op een bepaalde kankerbehandeling te voorspellen. En het OLVG-ziekenhuis in Amsterdam vraagt sinds kort advies aan AI om te bepalen of patiënten de IC kunnen verlaten.

Deze innovaties worden in rap tempo overgenomen door ziekenhuizen in heel Nederland. Ze zijn nog niet perfect: veel is bijvoorbeeld afhankelijk van de data waarop een algoritme getraind is. Zitten in de trainingsdata voor een huidkanker-algoritme betrekkelijk weinig scans van de huid van zwarte mensen, dan kan het algoritme minder accuraat zijn als de patiënt zwart is.

5 Wat is AI-kunst?

Er wordt op verschillende manieren geïnnoveerd met artificiële intelligentie in de kunst. Soms gaat het om de snelle reproductie van werk van kunstenaars die al bestaan (hebben). Denk bijvoorbeeld aan The Beatles, die een oude John Lennon-opname in een vol lied veranderden met hulp van AI, of experimenten met volledig door AI gegenereerde nummers van Drake en The Weeknd. Spotify heeft er inmiddels een dagtaak aan om AI-nummers weer te verwijderen.

Disney gebruikte kortgeleden AI om de openingstitels van de serie Secret Invasion aan te maken. De makers zouden voor de methode hebben gekozen omdat AI-beelden vaak nog net een beetje onwerkelijk lijken, wat paste bij de lading van de serie. Het leverde het bedrijf veel kritiek op, omdat het ook menselijke kunstenaars had kunnen inschakelen.

Andere kunstenaars spelen met hoe ze opdrachten geven aan beeld- of tekst-AI, of proberen een soort pastiches te maken waarbij bestaande personages in andere omgevingen of op een andere manier worden vormgegeven. Ook de trend om filmpjes in de stijl van filmmaker Wes Anderson te maken bereikte AI: zo liet iemand AI een versie van The Lord of the Rings in de stijl van de Amerikaanse filmmaker maken.

Tot nog toe gaat het om experimenten, en roept AI-kunst nog veel weerstand op omdat het om misbruik van andermans gecopyrighte beelden zou gaan – immers is dergelijke AI getraind op bestaande kunst.

6 Wat doen mensen al met taalmodellen als GPT?

Binnen de meeste vakgebieden zullen er mensen zijn met een interesse in technologie die er ofwel systematisch, of ad hoc mee spelen. NRC-redacteur Stijn Bronzwaer deed begin dit jaar een rondgang om te zien hoe ChatGPT nu al gebruikt werd.

Zo gebruikte techondernemer Angelique Schouten ChatGPT om een inhoudsopgave voor haar boek samen te stellen. Een webshopeigenaar gebruikt het programma om de eerste voorzet te doen voor blogs en productomschrijvingen, een programmeur laat ChatGPT suggesties doen om bepaalde programmeerproblemen op te lossen. Het taalmodel wordt ook al veel gebruikt om standaardmails op te stellen en om de klantenservice te regelen.

Ook in de journalistiek wordt momenteel veel geëxperimenteerd met AI-taalmodellen. Bijvoorbeeld om korte nieuwsberichten te maken, of om moeilijke academische teksten samen te vatten om literatuuronderzoek te bespoedigen. Wel gaat het gebruik van taalmodellen soms goed mis: een Amerikaanse jurist kreeg flink op zijn kop van de rechter toen hij kwam aanzetten met verwijzingen naar zaken die nooit hadden plaatsgevonden. ChatGPT had deze zaken bij elkaar ‘gehallucineerd’ – de man checkte van tevoren niet of ze echt bestonden.

7 Wat zijn de interessantste AI-programma’s voor mij?

Er is een bijzonder groot en groeiend aanbod aan apps die gebruik maken van taal- en beeldmodellen om nieuwe diensten aan te bieden. Doorgaans maken ze allemaal gebruik van bijvoorbeeld een ChatGPT of een Stable Diffusion: in principe kun je ook gewoon met die basismodellen aan de slag, en zijn veel tooltjes vooral wat aangescherpte versies van die modellen. Op TheresAnAIForThat.com komen maandelijks nieuwe tools voorbij, van maaltijdplanners als Mealmind.io tot interieuradviessites als InteriorAI. Vaak zijn deze tools nog experimenteel, en verrichten ze geen grote wonderen. Bovendien is het zinnig om bij elke tool even te controleren wat hun ethische code is, al is het maar ter informatie.

Wil je je eigen stem ‘automatiseren’ of iets laten inspreken door een computerstem, dan is sinds afgelopen week Eleven Labs ook in Nederland beschikbaar, een AI die je onder andere je eigen stem laat klonen. Het bestaan van deze app heeft echter ook een flinke keerzijde: in de Verenigde Staten wordt er al volop gefraudeerd door criminelen die stemmen van bekenden na te doen aan de telefoon. Wil je video maken, dan heb je wellicht iets aan Synthesia. Met een tool als Soundraw kun je AI rechtenvrije muziek laten maken.

Bewerk je liever wat je hebt, dan zijn er ook zat hulptools op de markt. Denk aan Podcastle voor audio-editing, aan Descript voor videomontage via het aanpassen van je script of Fireflies voor het notuleren van Zoom-gesprekken. En wil je gewoon wat spelen met familiefoto’s, dan is er Cleanup.Pictures voor het verwijderen van ongewenste voorwerpen uit foto’s, of Deep Nostalgia van MyHeritage, dat oude foto’s animeert.

Wat zijn de risico’s van AI?

1 Is er risico op een ‘killer AI’ zoals in sciencefictionfilms?

Kunstmatige intelligentie wordt in films als Terminator vaak weergegeven als een robot of systeem dat zelfstandig beslissingen kan nemen, en vaak kil besluit om mensen te doden. Dergelijke zelfbewuste systemen bestaan niet. De huidige ‘machine learning’-intelligenties zijn goed in patroonherkenning en het reproduceren van die patronen, maar kunnen niet zelf beslissingen nemen of echt nadenken. Ze zoeken alleen maar in het geheugen naar wat het meest waarschijnlijke antwoord is op de vraag die je gesteld hebt.

Momenteel wordt er wel gewerkt aan intelligenties die de zogenoemde ‘Theory of mind’ zouden kunnen ontwikkelen. Dat is een concept uit de psychologie, die slaat op het vermogen van een wezen om te beseffen dat een ander wezen eigen gedachten en gevoelens heeft. Uit recent onderzoek aan de universiteit van Stanford blijkt dat een taalmodel als ChatGPT inmiddels wel kan doen ‘alsof’, op het niveau van een 9-jarig kind. Het is echter waarschijnlijk dat ChatGPT simpelweg patronen herhaalt – een eigen bewustzijn heeft de chatbot niet.

‘Theory of Mind’ is de volgende stap op weg naar systemen die daadwerkelijk zelfbewust zijn. Zover zijn we dus nog niet. Momenteel is de kans veel groter dat AI een negatieve impact heeft door iets wat een mens ermee doet, dan dat die zelf snode plannen gaat bedenken. Denk aan het Amerikaanse leger, dat momenteel experimenteert met drones die op afstand doelwitten uitschakelen met behulp van AI – en dat op termijn misschien zelfs zonder menselijke inbreng kunnen.

2 Maakt een chatbot misbruik van wat ik er tegen zeg?

Dat ligt eraan wat je als ‘misbruik’ ziet. De bekende chatbots bevinden zich nog in een teststadium en maken gebruik van alles wat je tegen ze zegt om verder te trainen. Ook wanneer jij aangeeft dat je een antwoord niet goed vindt, wordt jouw klacht door het systeem gebruikt om zichzelf bij te stellen.

De verschillende chatbots waarschuwen dan ook doorgaans dat je geen vertrouwelijke informatie moet blootgeven aan de AI. Die kan daar vanaf dat moment van alles mee doen. Wat we níét weten, is in hoeverre mensen ook meespieken en meelezen. In principe ben je het veiligst als je er bij voorbaat vanuit gaat dat ze dat wel doen.

3 Hoe ver zijn we in de ontwikkeling van een ‘superintelligentie’?

Binnen de artificiële intelligentie wordt er grofweg gesproken van drie niveau’s voor AI. Een ‘artificial narrow intelligence’ is een programma dat getraind is om een specifieke taak goed uit te voeren. Hieronder vallen alle bestaande kunstmatige intelligenties.

Momenteel ontwikkelen de grote AI-bedrijven op het tweede niveau, de ‘artificial general intelligence’. Dat is een intelligentie die in staat is om te leren taken uit te voeren door na te denken over andere taken die het gedaan heeft. Steve Wozniak, één van de oprichters van Apple, formuleerde de ‘koffietest’ om te bepalen of een AI ‘general intelligence’ heeft. De koffietest houdt in dat een intelligentie in een onbekend huis koffie moet kunnen zetten: dus koffiemachine, kop en filters vinden, en de koffiemachine bedienen.

Pas na deze ‘general intelligence’ volgt de stap van een echt bewustzijn, een AI die niet alleen taken kan leren, maar zich ook bewust is van zijn eigen belevingswereld en die van anderen. Daar zijn we nog lang niet: bestaande AI aapt slechts menselijke gedachten na. Hoe snel de ontwikkelingen in de toekomst gaan lopen, is niet met zekerheid te zeggen.

4 Waarom waarschuwen experts voor AI?

Veel AI-onderzoekers stapten het afgelopen jaar naar de media om te waarschuwen voor de gevaren rond AI. Vaak hebben ze het over grote existentiële zorgen als het risico op het uitsterven van de mensheid door AI. Partijen zoals de Nederlandse ngo Existential Risk Observatory waarschuwen dat er een kans van zo’n 10 procent is dat AI op eigen houtje het uitsterven van de mens zal veroorzaken, ergens in de komende 100 jaar. Dat zou kunnen gebeuren als AI aan onze controle ontsnapt en andere systemen inglipt.

Andere critici vinden dat deze toekomstwaarschuwingen de aandacht afleiden van wat er nu al misgaat. Zoals de manier waarop techbedrijven grootschalig data verzamelen voor hun systemen, en de gevolgen van ons onvermogen om te zien waarom huidige intelligente systemen doen wat ze doen. ‘Machine learning’ maakt het namelijk lastig om precies te zien welke afwegingen een netwerk maakt. Als een taalmodel opeens racistische taal gaat uitslaan, zoals gebeurde met Microsofts taalbot Tay in 2016, is dat moeilijk te herleiden en te corrigeren.

Anderzijds spreken critici zich ook uit over de manier waarop bedrijven gebruikmaken van kunstmatige intelligentie. Een bedrijf als Disney zou bijvoorbeeld taalmodellen kunnen inzetten om scenario’s te schrijven, en vervolgens schrijvers voor weinig geld vragen om die scenario’s op te poetsen tot iets bruikbaars. Op dit moment staken de Hollywoodschrijvers omdat filmbedrijven niet willen beloven dat ze dat niet zullen doen. Ook kan AI gemakkelijk worden misbruikt voor gezichtsherkenningssystemen, zoals nu al wordt ingezet in China.

Ten slotte maken overheden en wetenschappers zich ook concreet zorgen over de mogelijkheid om AI te gebruiken om mensen te misleiden. Bijvoorbeeld als oplichters via AI iemands stem nadoen aan de telefoon, of bij de verspreiding van nepnieuws tijdens de verkiezingen. Een nepfoto waarin een kandidaat iets gruwelijks doet is snel gemaakt, en fraude met gekloonde stemmen is in opkomst.

5 Kan ik mijn teksten of beelden beschermen tegen AI?

Bedrijven als OpenAI en Google maken doorgaans gebruik van grote databases van publiekelijk te verkrijgen teksten en beelden om hun modellen te trainen. Maar dat iets openbaar op internet staat, hoeft niet per se te betekenen dat er geen copyright op rust. Daarom stapten bedrijven als beeldbank GettyImages en schrijvers zoals cabaretier Sarah Silverman afgelopen jaar naar de rechtbank: ze vinden dat hun materiaal onrechtmatig is gebruikt. In deze zaken is nog geen uitspraak gedaan, maar ze zullen vermoedelijk een precedent stellen. The New York Times heeft in ieder geval een voorschot genomen: in hun algemene voorwaarden wordt nu het inzamelen van hun data voor AI verboden.

Ondertussen blijven zogenoemde ‘bots’ regelmatig informatie van het internet plukken. Websites die grote hoeveelheden tekst bevatten worstelen daarom met de aanpak van deze verzamelaars: je kan het wel lastig maken om grootschalig tekst van je site te downloaden, maar dan kunnen ook wetenschappers en andere goedbedoelende geïnteresseerden de teksten niet meer gemakkelijk downloaden.

Beschermen kán dus wel, maar vereist drastische maatregelen, zoals een wachtwoordslot of kopieerbeveiliging op de site. Ook zijn er diensten die automatisch de toegang blokkeren als ze merken dat een computer wel heel veel informatie opvraagt. Verder kan de beheerder van een site in het bestandje ‘robot.txt’ aangeven welke pagina’s een bot wel en niet mag opslaan, maar veel bots letten hier niet meer op.

6 Doen AI-bedrijven ook moeite om ongewenste teksten uit de chatbots te weren?

Ja. Het is vrij lastig om racistische, seksistische en andere ongewenste uitingen te filteren: je weet immers niet wat een taalmodel geleerd heeft uit de dataset, en zomaar bijstellen gaat ook niet. Waar bedrijven wel controle over hebben, is de data die ze in het systeem stoppen om het te trainen. Maar ook daar geldt: het gaat om zoveel data dat het vrijwel onmogelijk is om alles er met de hand uit te halen.

In plaats daarvan besloot OpenAI een dataset te bouwen waarmee een AI getraind kon worden om ongewenst materiaal te spotten en te verwijderen. Dit werk werd uitbesteed aan een bedrijf uit Kenia. Volgens Time werden de werknemers van het bedrijf uiteindelijk zo’n 2 dollar per uur betaald om seksistische, racistische en gewelddadige teksten van labels te voorzien zodat de AI kon leren om die te herkennen. Dit werk zou traumatiserend zijn geweest voor de werknemers en het bedrijf besloot daarom de samenwerking met OpenAI te beëindigen.